Créer un cluster de basculement de serveurs Hyper-V sous WS 2012 R2 ou WS 2016

- Microsoft

- 29 novembre 2019 à 11:34

-

- 2/6

2. Création du cluster

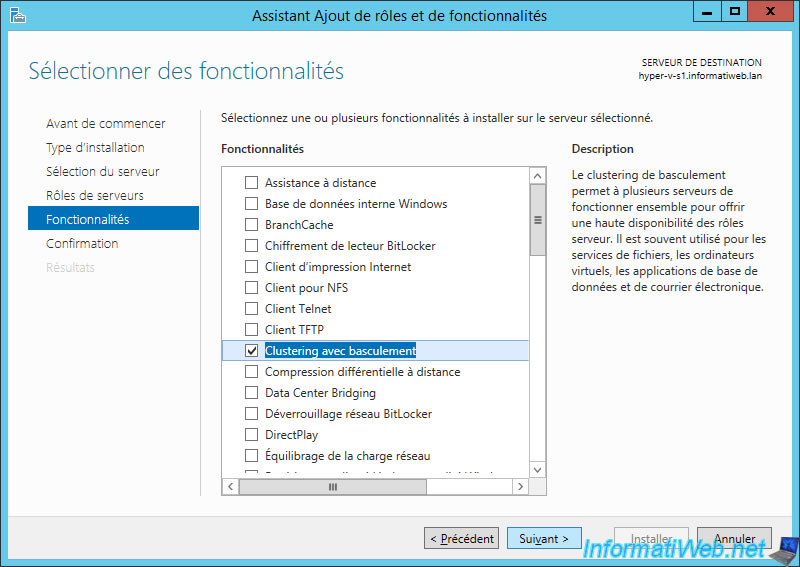

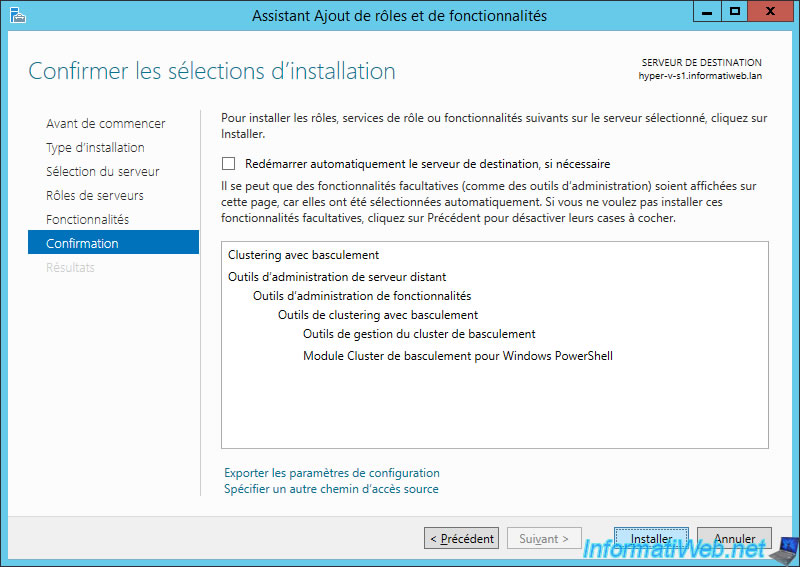

2.1. Installation de la fonctionnalité : Clustering avec basculement

Sur vos serveurs Hyper-V, lancez l'assistant Ajout de rôles et de fonctionnalités et installez la fonctionnalité : Clustering avec basculement.

Note : sous Windows Server 2016, le nom est "Clustering de basculement".

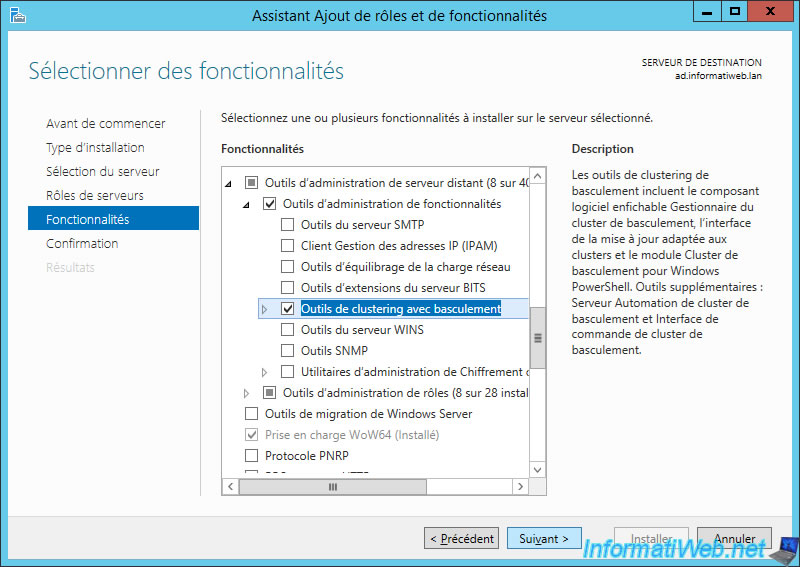

Etant donné qu'un noeud de votre cluster peut tomber à n'importe quel moment, vous gérerez certainement votre cluster depuis un serveur situé en dehors de votre cluster Hyper-V.

Pour cela, vous aurez besoin des outils de gestion de votre cluster.

Sur un serveur de votre réseau, installez la fonctionnalité "Outils de clustering avec basculement" disponible dans : Outils d'administration de serveur distant -> Outils d'administration de fonctionnalités.

Ainsi que la fonctionnalité "Outils d'administration Hyper-V" disponible dans : Outils d'administration de rôles.

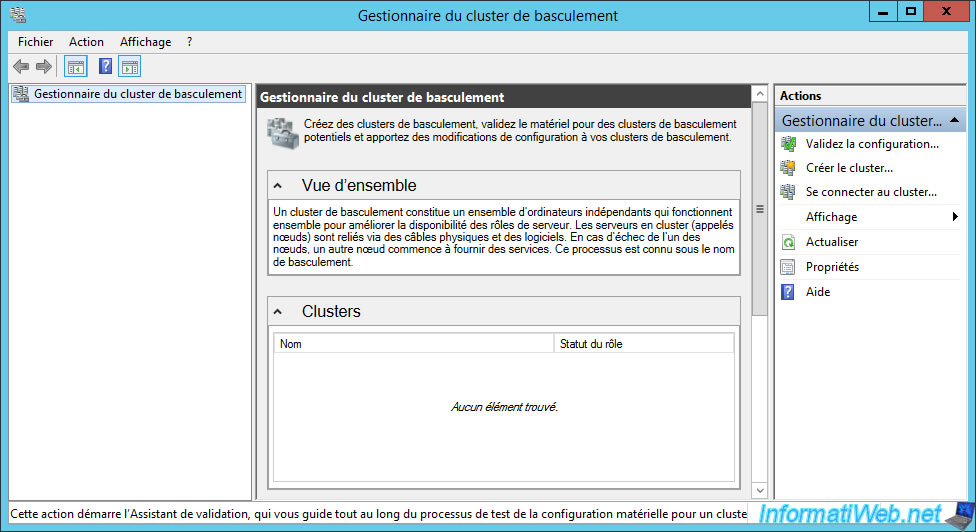

2.2. Validation de la configuration de vos serveurs pour le cluster

Avant de créer votre cluster Hyper-V, il est très important de valider la configuration des serveurs qui en feront partie.

Pour cela, ouvrez le gestionnaire du cluster de basculement et cliquez sur : Validez la configuration.

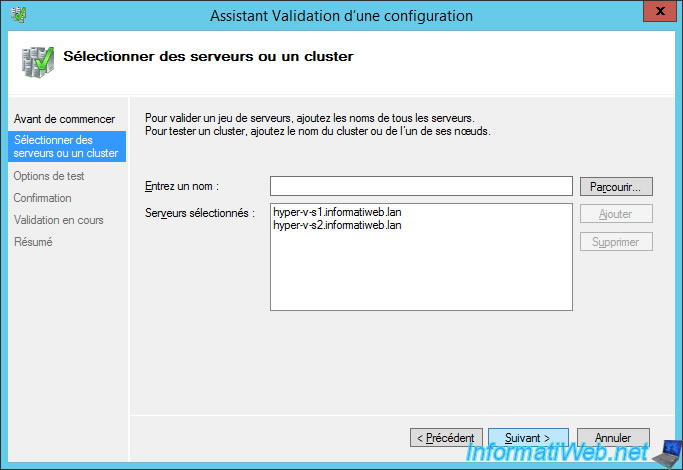

Ajoutez un à un les serveurs à vérifier.

Dans notre cas :

- hyper-v-s1.informatiweb.lan

- hyper-v-s2.informatiweb.lan

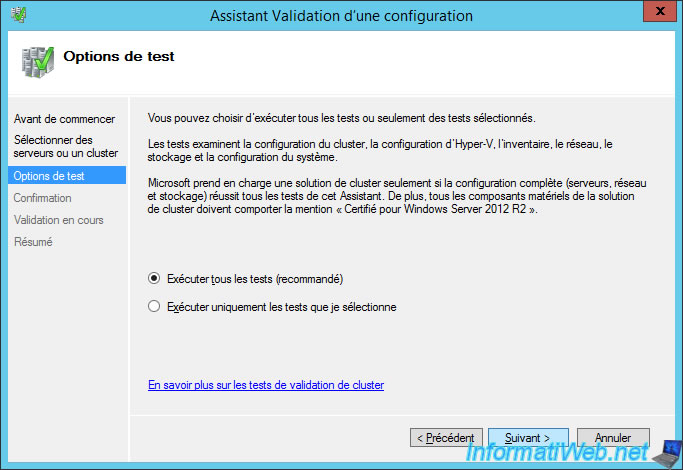

Laissez l'option "Exécuter tous les tests (recommandé)" sélectionnée et cliquez sur Suivant.

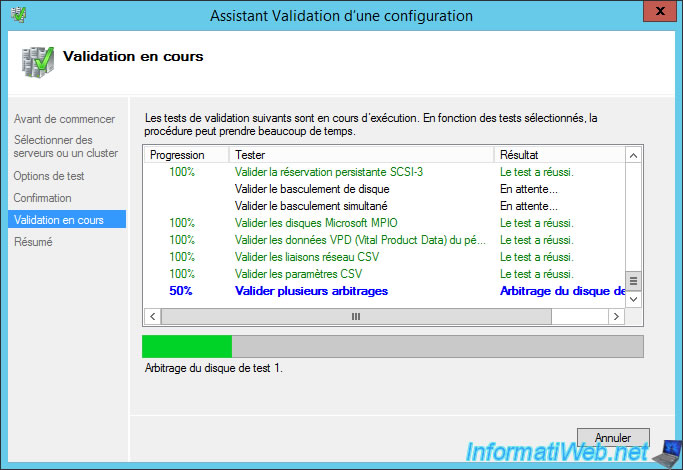

Patientez pendant la validation de la configuration de vos serveurs ET de la configuration Hyper-V de chacun d'eux.

Car, vous verrez que des erreurs peuvent aussi se produire concernant la configuration des paramètres Hyper-V.

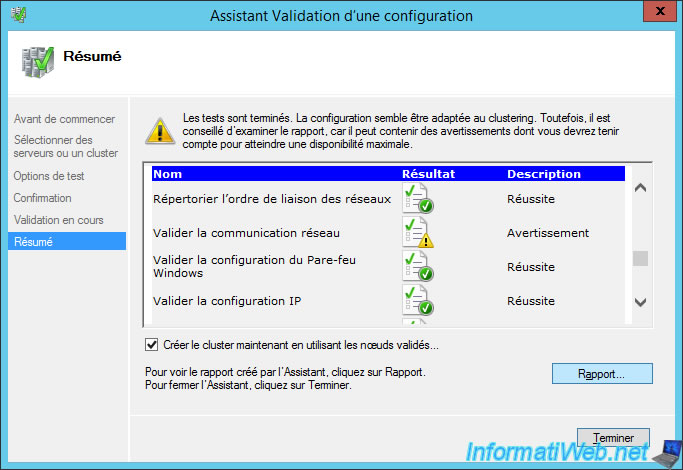

Lorsque tous les tests auront été effectués, vous pourrez consulter le rapport généré par l'assistant.

Cliquez sur le bouton "Rapport".

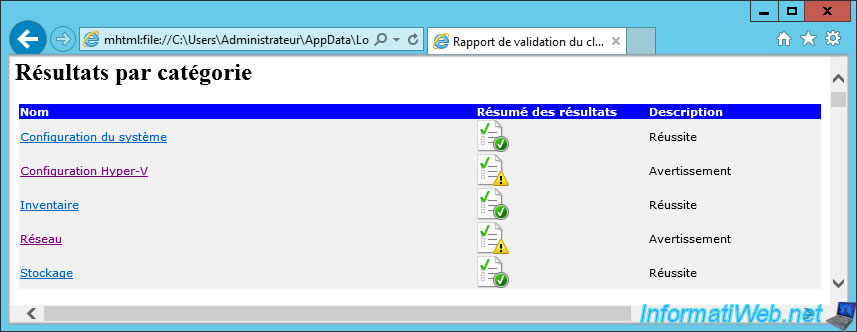

Une page web apparait avec un résumé par catégorie en haut.

Dans notre cas, nous avons des avertissements (pas des erreurs) pour :

- la configuration Hyper-V

- le réseau

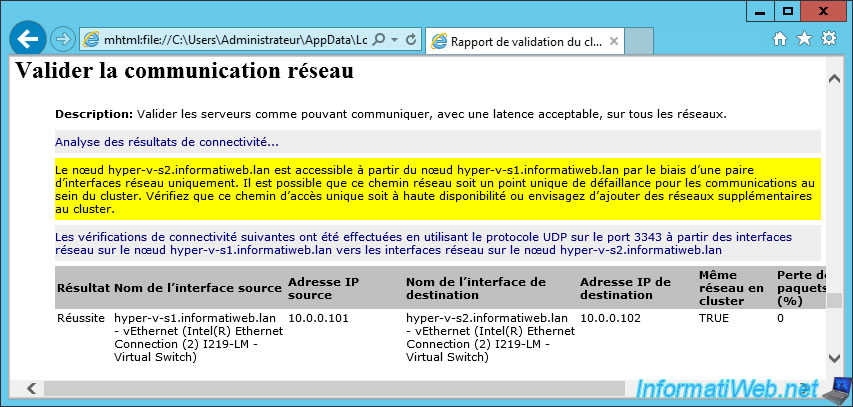

Pour la configuration réseau, il s'agit simplement de la communication réseau qui est possible par un seul chemin au lieu de 2.

Ce qui crée un point unique de défaillance.

Néanmoins, nous n'avions pas la possibilité (au niveau matériel) d'utiliser 2 cartes réseau pour ce tutoriel.

Ceci dit, en production, il est évidemment fortement recommandé de pouvoir obtenir 2 chemins de communication réseau pour éviter :

- qu'un noeud soit exclu dans le cas où sa carte réseau tomberait en panne

- ou que le cluster entier ne tombe à cause d'un switch défectueux

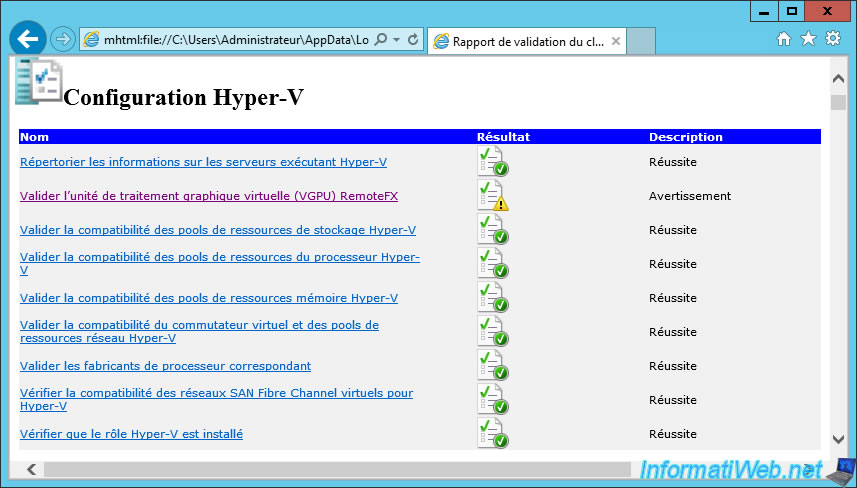

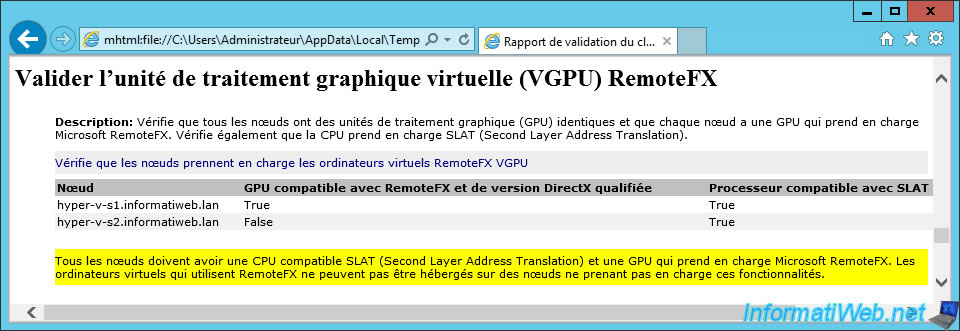

Pour la configuration Hyper-V, l'avertissement concerne l'unité de traitement graphique virtuelle (VGPU) RemoteFX.

Comme vous pouvez le voir, l'assistant à vérifier que vos noeuds utilisent des cartes graphiques (GPU) identiques et qu'elles sont compatibles avec Microsoft RemoteFX.

L'assistant a aussi vérifié que le processeur (CPU) de vos noeuds supporte le SLAT (Second Layer Address Translation).

Comme vous pouvez le voir, dans notre cas, l'assistant nous indique que le 1er serveur est compatible avec RemoteFX et que le 2ème ne l'est pas.

Pourtant, nos 2 serveurs sont strictement identiques et ils possèdent donc exactement le même processeur et la même carte graphique.

La seule différence est qu'un de nos serveurs Hyper-V avait été configuré pour prendre en charge Microsoft RemoteFX et l'autre non.

2.3. Activer le support de RemoteFX sur vos serveurs Hyper-V

Pour pouvoir activer le support de RemoteFX sur vos serveurs Hyper-V, vous devrez d'abord installer le service de rôle "hôte de virtualisation des services Bureau à distance" sur ceux-ci.

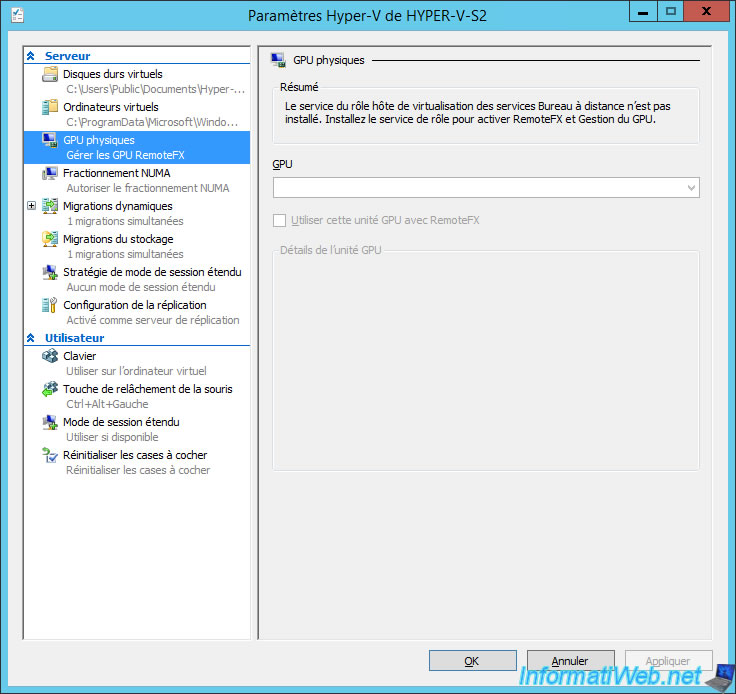

Ce pré-requis est d'ailleurs indiqué dans les paramètres Hyper-V de vos serveurs Hyper-V lorsque ce rôle n'est pas installé.

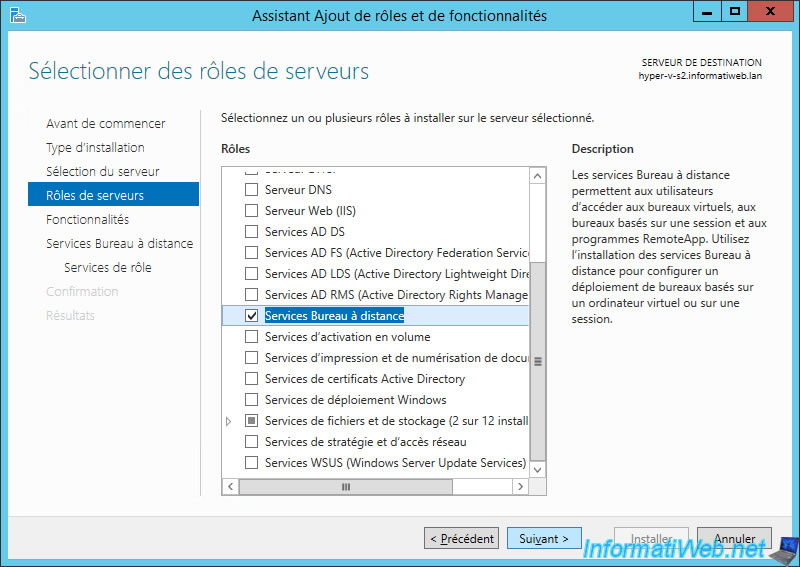

Sur vos serveurs Hyper-V, cochez le rôle "Services Bureau à distance" (qui correspond à RDS).

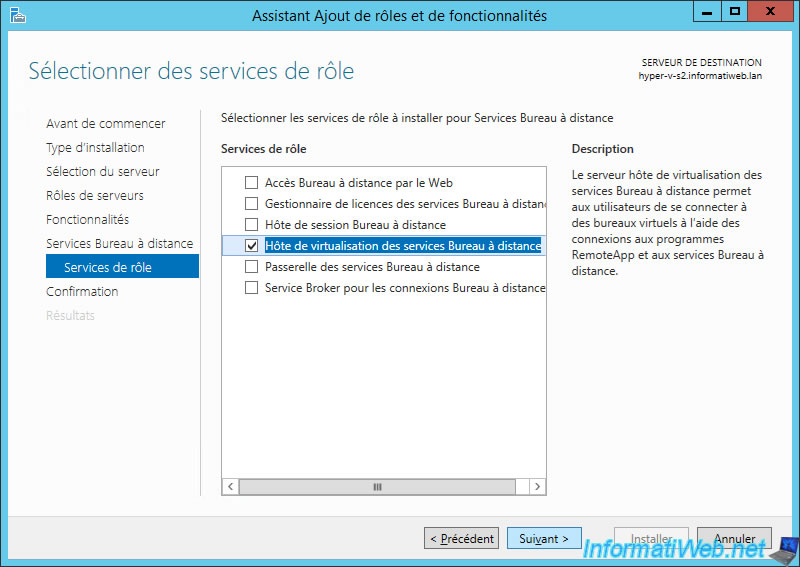

Puis dans les services de rôles proposés, cochez uniquement la case "Hôte de virtualisation des services Bureau à distance".

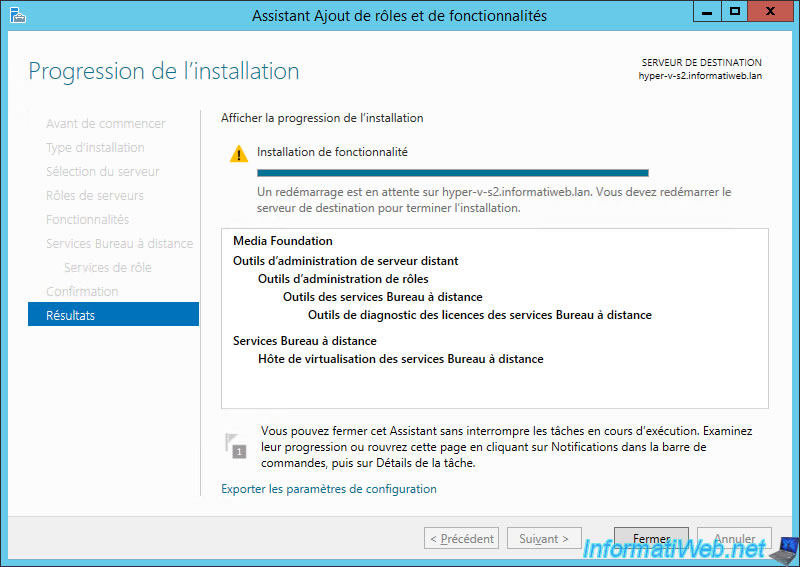

Notez qu'un redémarrage sera probablement nécessaire pour terminer l'installation de ce service de rôle.

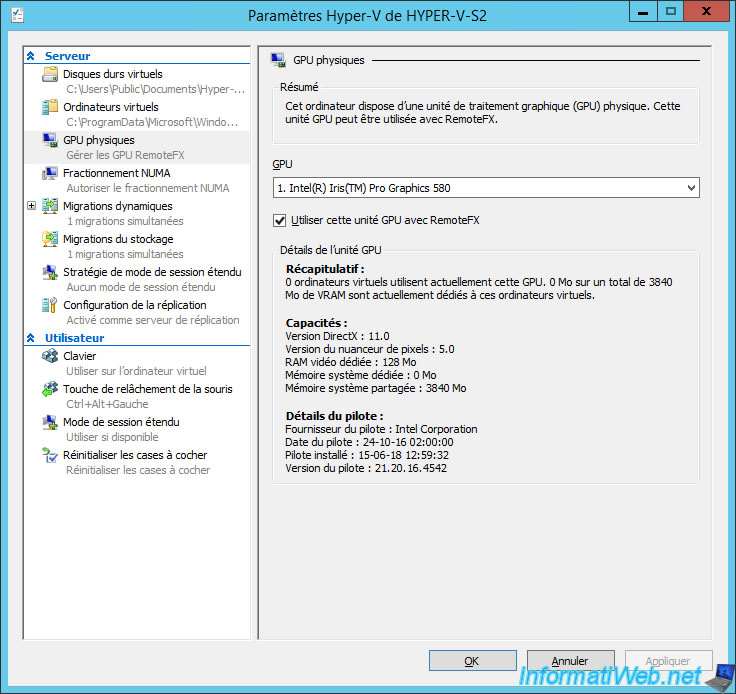

Ensuite, dans les paramètres Hyper-V de vos serveurs Hyper-V :

- allez dans : GPU physiques

- sélectionnez la carte graphique de votre serveur à utiliser

- cochez la case : Utiliser cette unité GPU avec RemoteFX

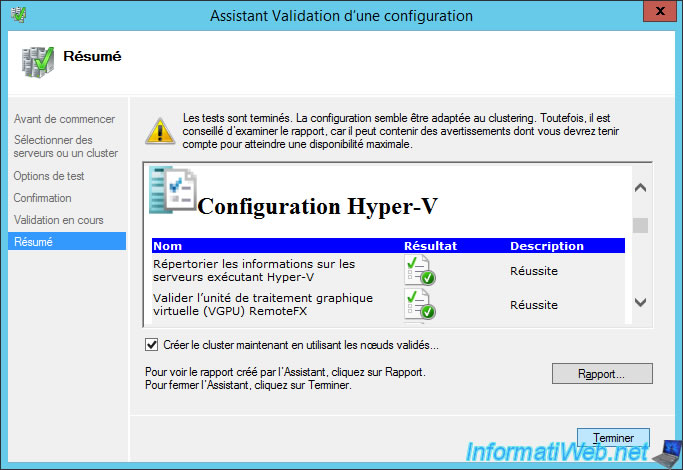

Une fois que le support de RemoteFX sera installé et configuré de manière identique sur vos serveurs Hyper-V, le test "Valider l'unité de traitement graphique virtuelle (VGPU) RemoteFX" sera validé.

Note : nous avons relancé l'assistant de validation pour vous prouver que cet avertissement était simplement dû à ce petit détail.

A la fin de l'assistant Validation d'une configuration, laissée la case "Créer le cluster maintenant en utilisant les noeuds validés" cochée et cliquez sur Terminer.

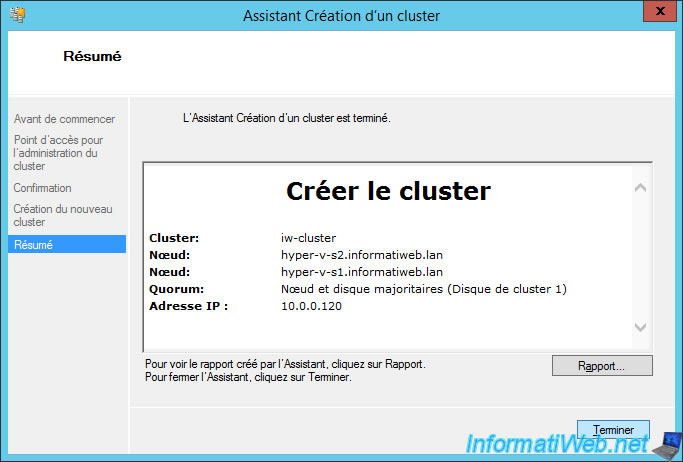

2.4. Création du cluster Hyper-V

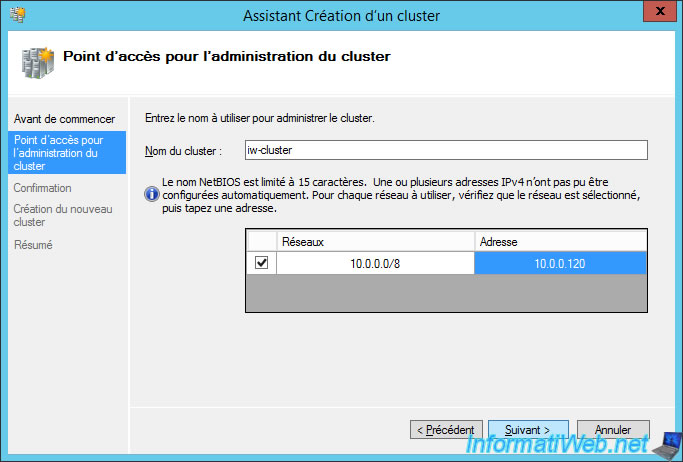

L'assistant Création d'un cluster apparait.

Indiquez un nom pour votre cluster, ainsi que l'adresse IP qui lui sera attribuée pour y accéder.

En effet, pour gérer votre cluster, vous devrez vous connecter à ce nom ou cette adresse IP et non à un des noeuds du cluster.

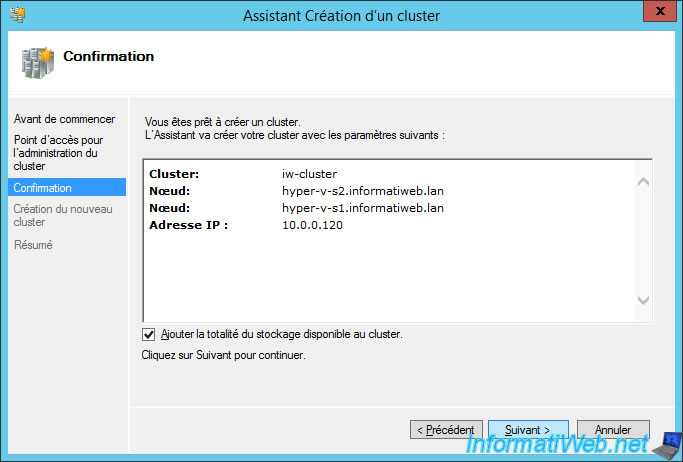

Cochez la case "Ajouter la totalité du stockage disponible au cluster" et cliquez sur Suivant.

Le cluster est créé.

Note : pour en savoir plus sur la configuration du quorum, référez-vous à notre tutoriel : Créer un cluster de basculement de serveurs de fichiers.

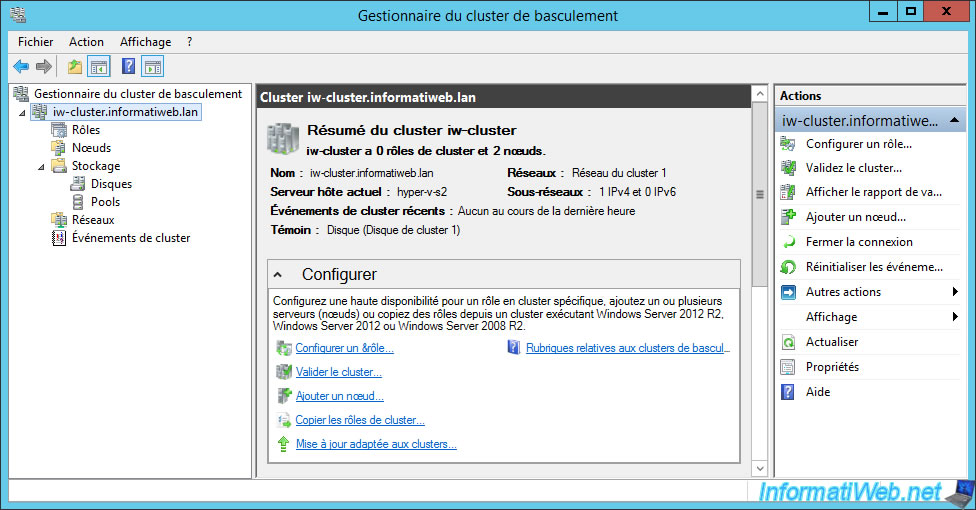

Votre cluster apparait.

Notez qu'à partir de maintenant, vous devriez gérer vos ordinateurs virtuels uniquement depuis le gestionnaire du cluster de basculement et non depuis le gestionnaire Hyper-V.

Lorsque vous voudrez créer de nouveaux ordinateurs virtuels, vous devrez donc le faire depuis gestionnaire du cluster de basculement pour que l'ordinateur virtuel puisse être basculé d'un noeud à un autre automatiquement si nécessaire et non depuis le gestionnaire Hyper-V du serveur concerné.

En effet, si vous passez par le gestionnaire Hyper-V, l'ordinateur sera créé localement sur votre serveur Hyper-V et non dans votre cluster.

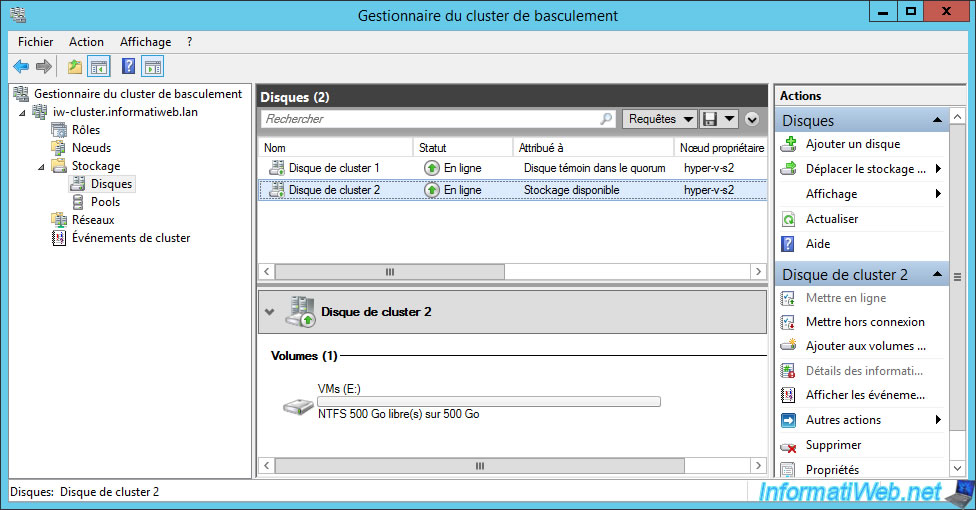

Dans le stockage de notre cluster, nous retrouvons nos 2 disques iSCSI créés précédemment :

- le disque témoin de 1 Go qui a été automatiquement en tant que Disque témoin dans le quorum

- le 2ème disque (de 500 Go dans notre cas) qui est actuellement disponible

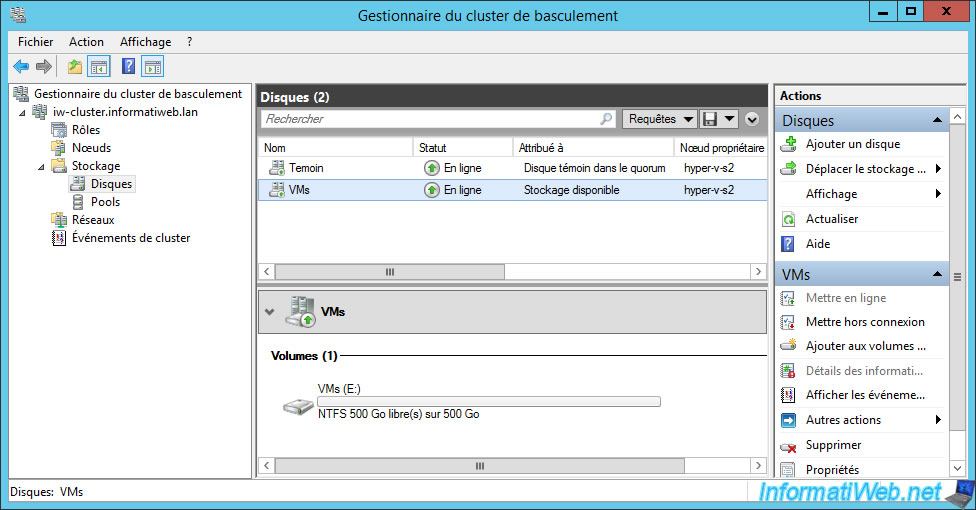

Nous vous recommandons de renommer directement vos disques pour y voir plus clair par la suite.

Pour cela, faites un double clic sur un disque ou faites un clic droit "Propriétés" sur celui-ci, puis modifiez son nom.

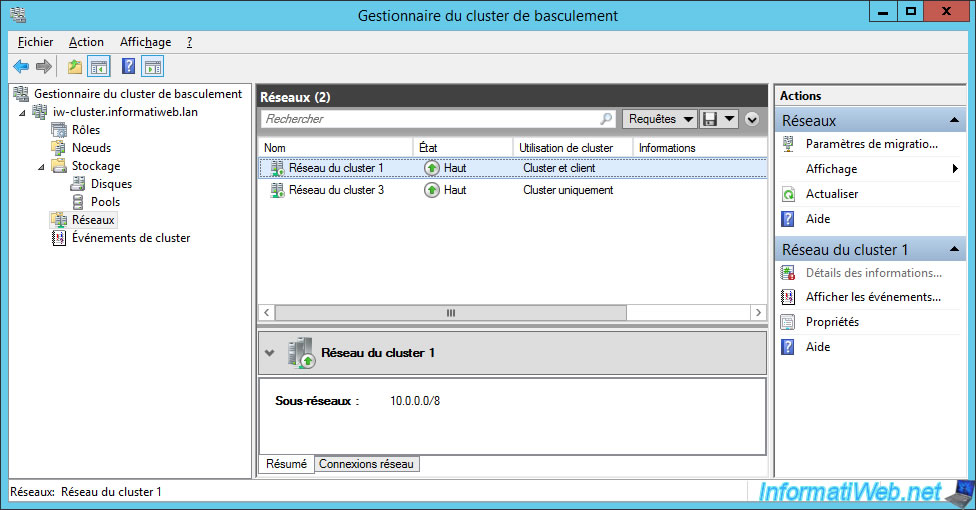

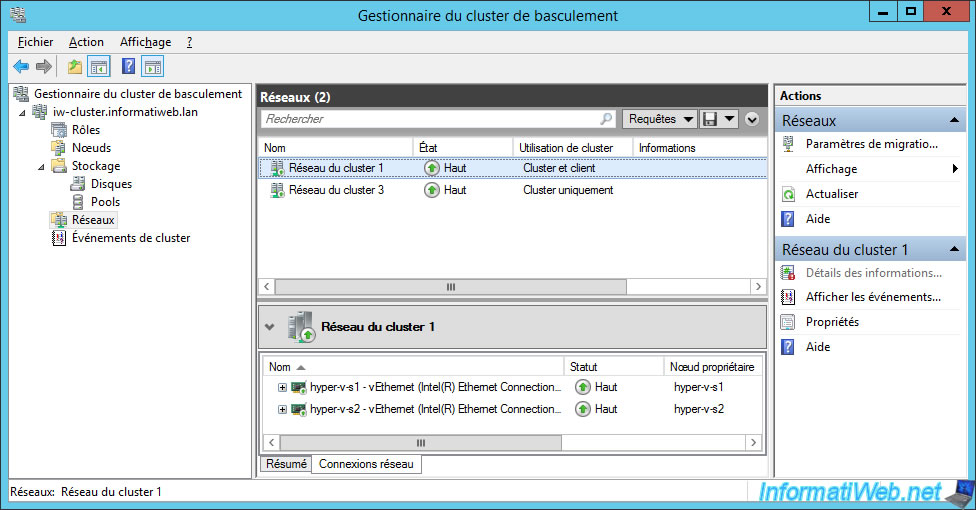

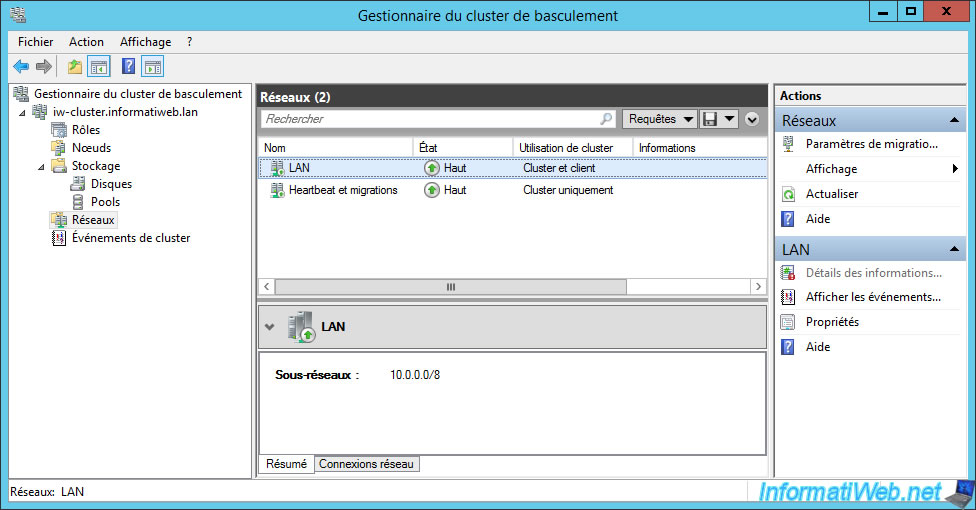

Pour les réseaux, vous verrez que nous en possédons 2 dans notre cas.

Notez que comme Hyper-V est bien entendu installé sur nos 2 noeuds, la carte réseau pour le réseau LAN s'appelle dans ce cas-ci : vEthernet (...).

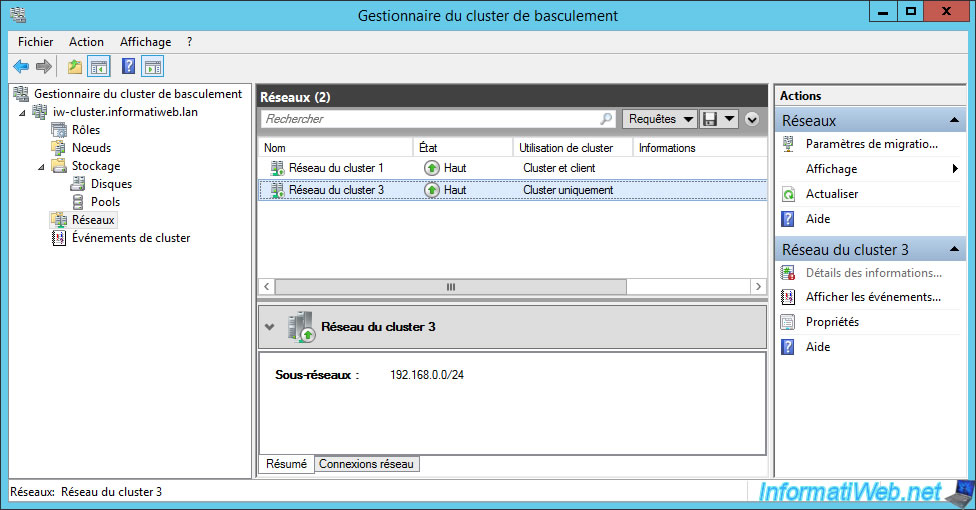

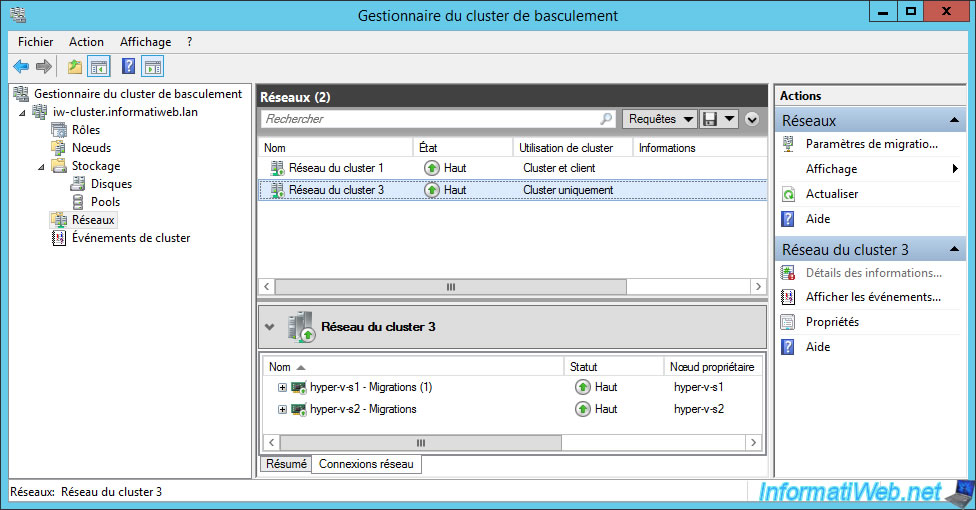

Pour le réseau Heartbeat permettant aux noeuds de détecter si les autres noeuds sont toujours disponibles ou non, celui-ci est configuré en "Cluster uniquement".

Notez que, pour ce tutoriel, nous utilisons aussi cette carte réseau pour les migrations dynamiques.

Néanmoins, en production, nous vous recommandons d'utiliser au moins 5 cartes réseau par noeud pour votre cluster Hyper-V :

- 1 pour le réseau LAN

- 1 pour le réseau Heartbeat

- 2 pour l'accès au serveur iSCSI via des chemins multiples (MPIO)

- 1 pour les migrations dynamiques de Hyper-V

Encore une fois, nous vous recommandons de renommer vos réseaux dans le gestionnaire du cluster de basculement pour y voir plus clair dans le futur.

Partager ce tutoriel

A voir également

-

Microsoft 6/9/2019

Hyper-V (WS 2012 R2 / 2016) - Créer une VM de génération 2

-

Microsoft 10/8/2019

Hyper-V (WS 2012 R2 / 2016) - Installer Hyper-V et créer son 1er ordinateur virtuel

-

Microsoft 12/10/2019

Hyper-V (WS 2012 R2 / WS 2016) - Améliorer les performances en utilisant un HDD physique

-

Microsoft 27/9/2019

Hyper-V (WS 2012 R2 / WS 2016) - Améliorer les performances graphiques avec RemoteFX

Pas de commentaire